Overview des concepts

multi modalité

- Texte (1D)

- classification (sentiment, …), (classic NLP)

- extraction (NER, POS), (classic NLP)

- texte libre (traduction, résumé, génération, analyse, ..) => LLMs

- Audio (2D): text to speech, speech to text

- image (2D) et video (3D + 2D) : text to image, text to video, image to video + synchronisation etc

Tokens, temperature

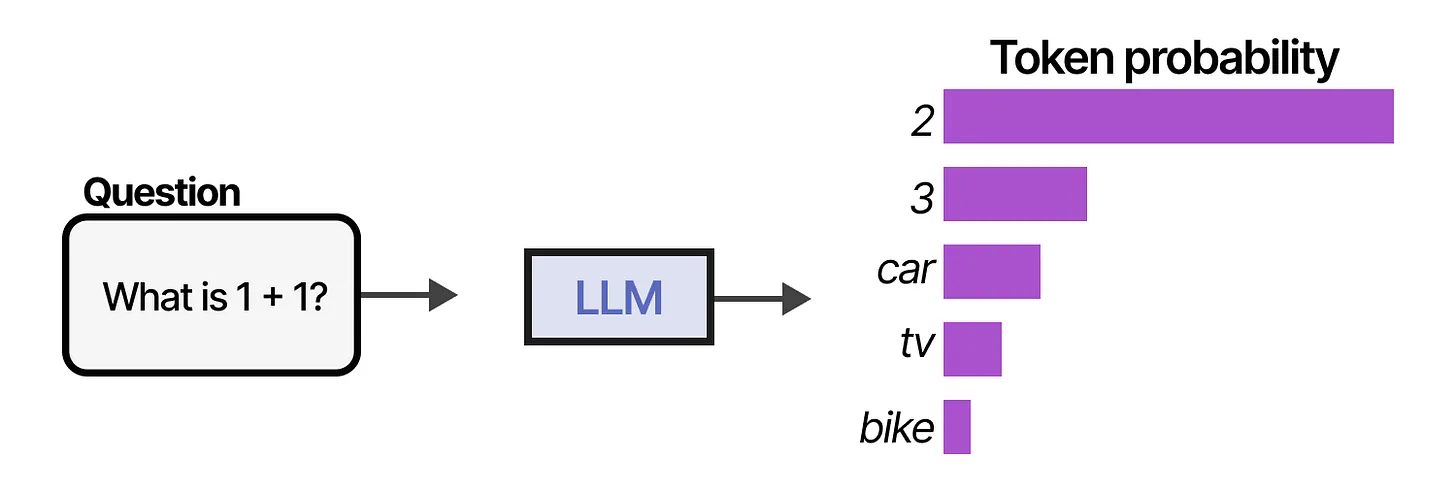

génération de texte :

- prediction du prochain token suivant une distribution de probabilité

- fenêtre de contexte et tokens:

- 1 token ≈ 0.75 mot, 1 page ~200 a 300 mots,

- 1M tokens = 1.3 guerre et paix

- température : paramètre qui permet de changer la distribution de probabilité des tokens

- plus ou moins de créativité

- plus ou moins d’hallucinations

temperature = 0ne veut pas dire determinisme

Pourquoi les tokens

- décomposition à peu près syllabique

- meilleure façon de compléter / prédire la suite d’un texte;

- pas de mots inconnus (OOV)

- vocabulaire de volume fini et de taille limitée,

- robuste vis à vis des erreurs de frappes, des formes des mots : conjugaisons, déclinaisons, accords etc

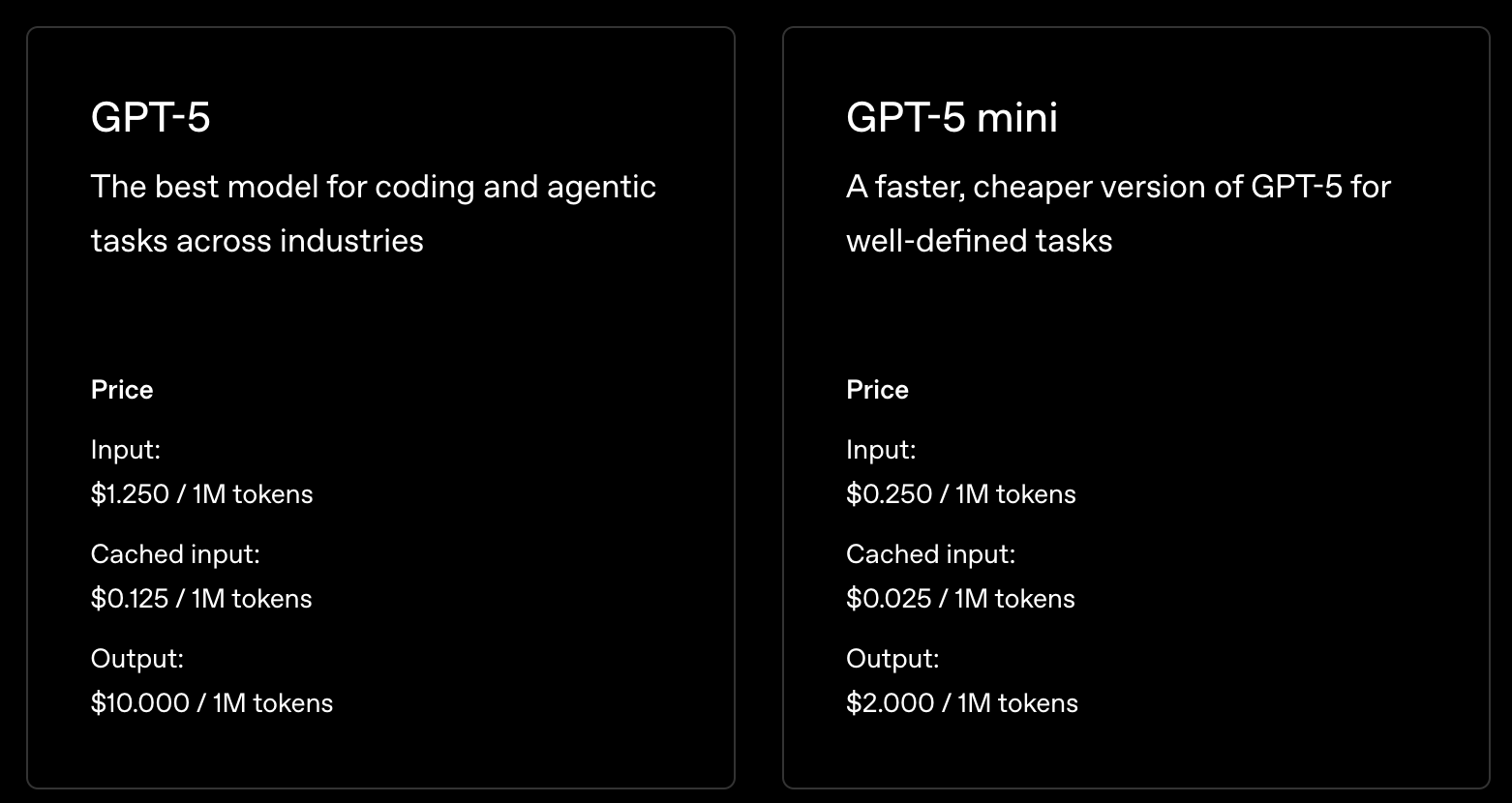

- le nombre de token dicte les coûts des requêtes vers les API.

- variation de prix par langue : Français plus cher que Anglais (x1.2)

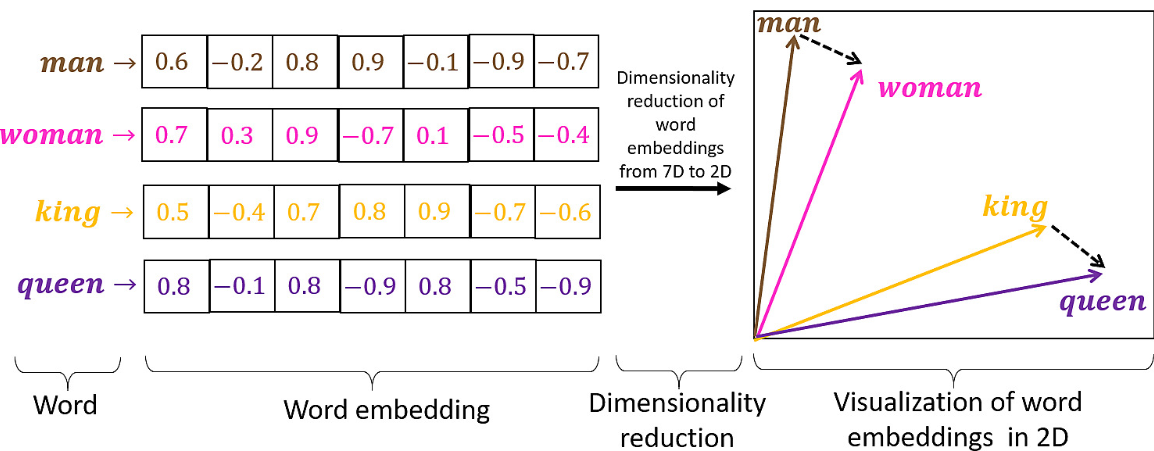

embeddings - vectorisation du texte

- texte -> vecteur

- cela donne une distance entre les textes qui respecte le sens des mots

- similarité sémantique :

d(chat, chien) < d(chat, banane) - il y a des modèles exclusivement dédiés à la création d’embeddings

modes d’utilisation

- plateforme : chatgpt.com, claude.ai, Mistral Le chat

- mais aussi : deepseek, qwen, gemini, …

- API: le code envoie une requête (prompt + modèle) vers une url (endpoint), et le serveur retourne le contenu demandé. vrai pour tout le web et pour les LLMs.

- le coût peut être important

- pléthore de modèles

- plateforme fédératrice de modèles via API

- huggingface : tous les modèles, LLMs et autres. Le repository mondial.

- groq (pas grok) , open routeur (modèles open source + rapidité)

- en local. on download le LLM et on le fait tourner en local. donc petit LLM, ok pour des tâches très spécifiques. gratuit. mais nécessite machine puissante.

Pour les acteurs de type OpenAI, Claude, etc : abonnement et API sont facturés distinctement

Pléthore de modèles

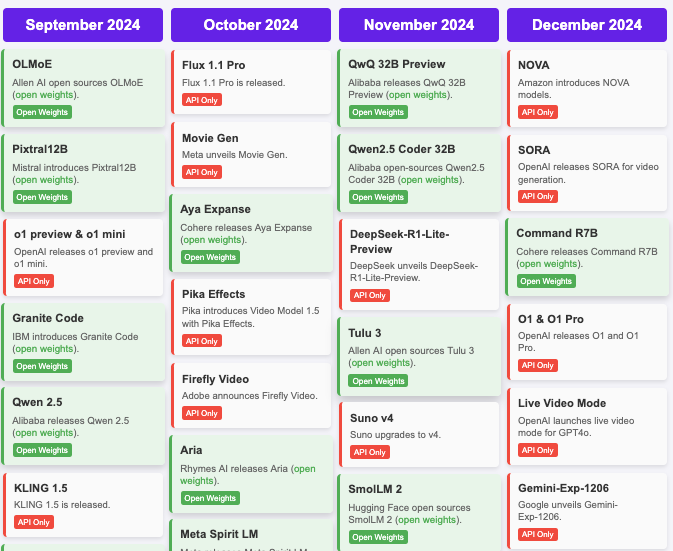

2024 AI Timeline - Hugginface release dashboards

Distinction majeure entre les modèles open source et closed source

Opensource vs Proprietaire: software

Open source:

- Le code est public : Linux

- Linux, OpenOffice, Firefox, Chromium, Python, grandes bases de données,

- Peut être copié et modifié par n’importe qui

Closed source:

- Le code n’est pas accessible.

- Windows, Word, Chrome, Edge, Oracle

- nécessite une licence pour utiliser, boîte noire

Open source LLMs

Différents niveaux d’ouverture :

- modèle : vous pouvez télécharger le modèle et l’utiliser tel quel => open weights

- code : le code pour créer le modèle

- données d’entraînement : les données utilisées pour entraîner le modèle

Certains modèles sont entièrement ouverts (DeepSeek), partiellement ouverts (Llama, Mistral 7B), ou fermés (OpenAI o1, Claude Sonnet, Gemini)

Si vous avez les poids d’un modèle vous pouvez le fine-tuner sur vos propres données. Version allégée de l’entraînement d’un modèle complet

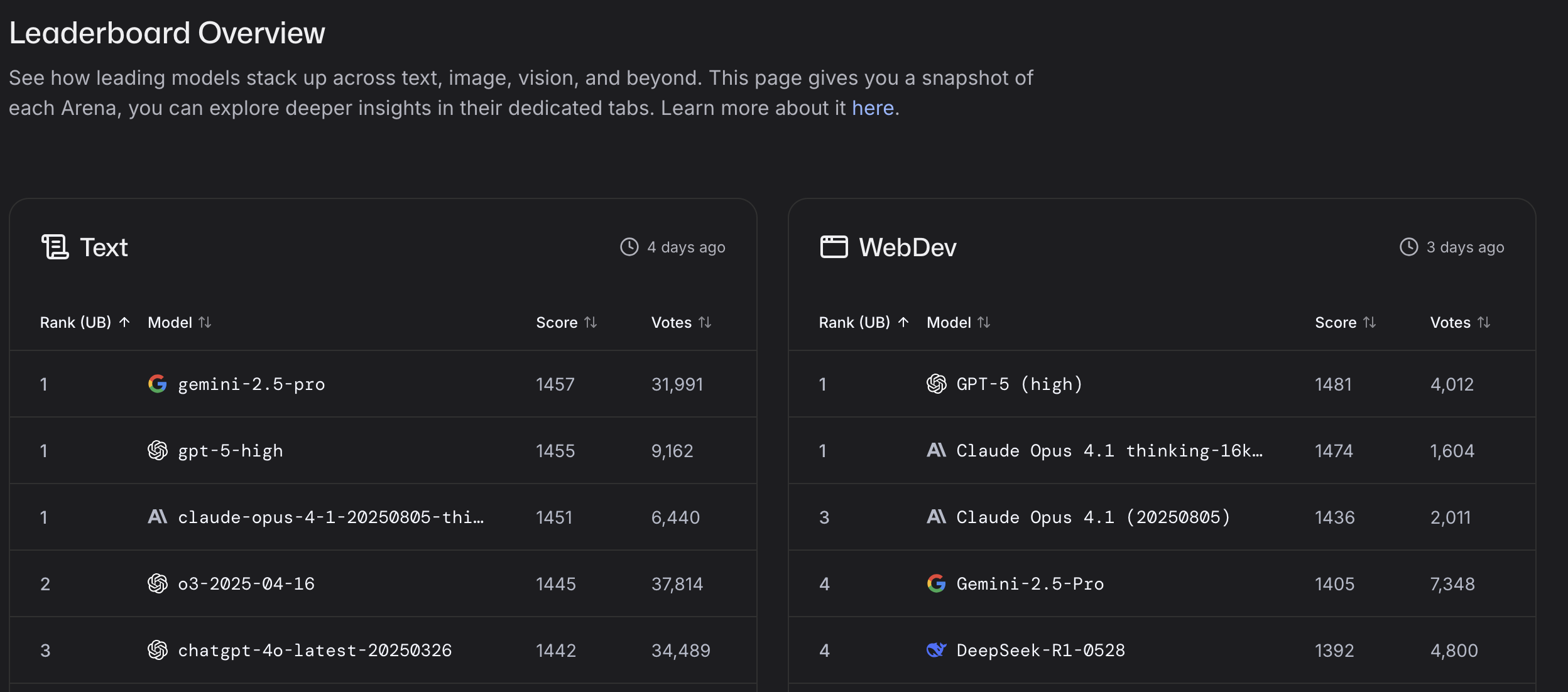

Performances comparées: LLM Benchmarks

Comment évaluer et comparer les LLMs ?

Les benchmarks LLM sont des suites de tests qui mesurent la performance des grands modèles de langage sur différentes tâches, comme répondre à des questions, résoudre des problèmes, ou écrire du texte. Ils permettent de comparer les modèles côte à côte.

Défis : Les benchmarks ne reflètent pas toujours l’usage du monde réel, peuvent devenir obsolètes rapidement, et les modèles s’entraînent souvent sur les tests, ce qui signifie que des scores élevés ne garantissent pas toujours une meilleure utilité.

Benchmarks traditionnels :

- MMLU Massive Multitask Language Understanding : 16 000 questions à choix multiples

- HellaSwag : Une machine peut-elle vraiment finir votre phrase ?

- HumanEval : Génération de code

- GSM8K Problèmes de mathématiques : 8K Q&R niveau école primaire

Problème : Les modèles saturent rapidement ces tests

La nouvelle frontière :

- GPQA Diamond : 198 QCM en biologie, chimie et physique, du niveau “licence difficile” au “niveau post-diplôme”.

- LiveCodeBench : benchmark d’évaluation sans contamination des LLMs pour le code qui collecte continuellement de nouveaux problèmes

- Humanity’s Last Exam : questions de près de 1 000 contributeurs experts de plus de 500 institutions dans 50 pays – composé principalement de professeurs, chercheurs et titulaires de diplômes supérieurs.

Ceux-ci représentent les limites cognitives de l’humanité

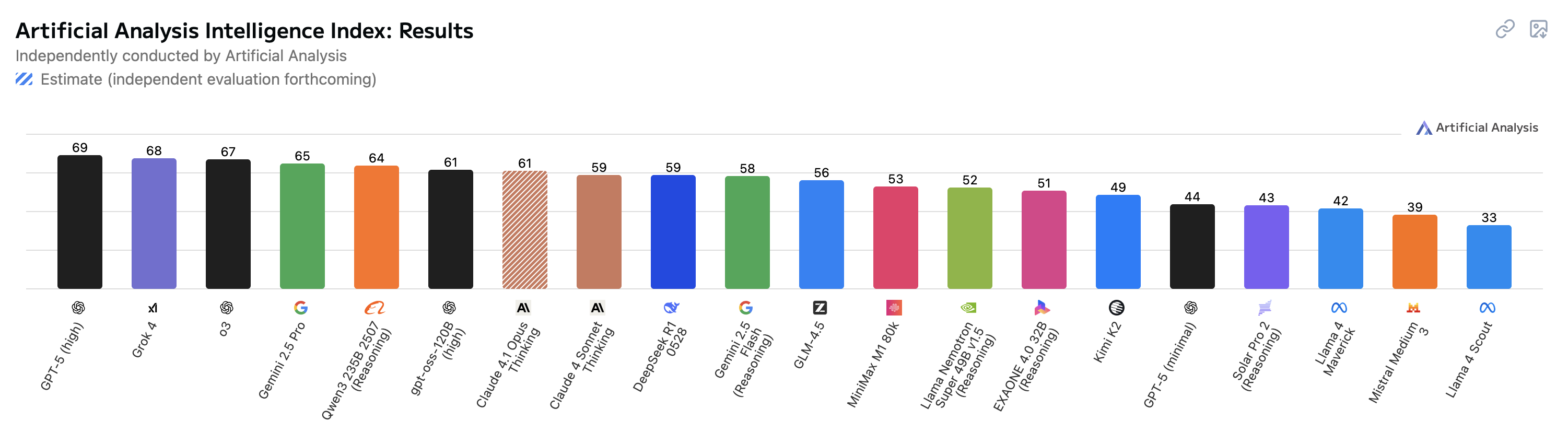

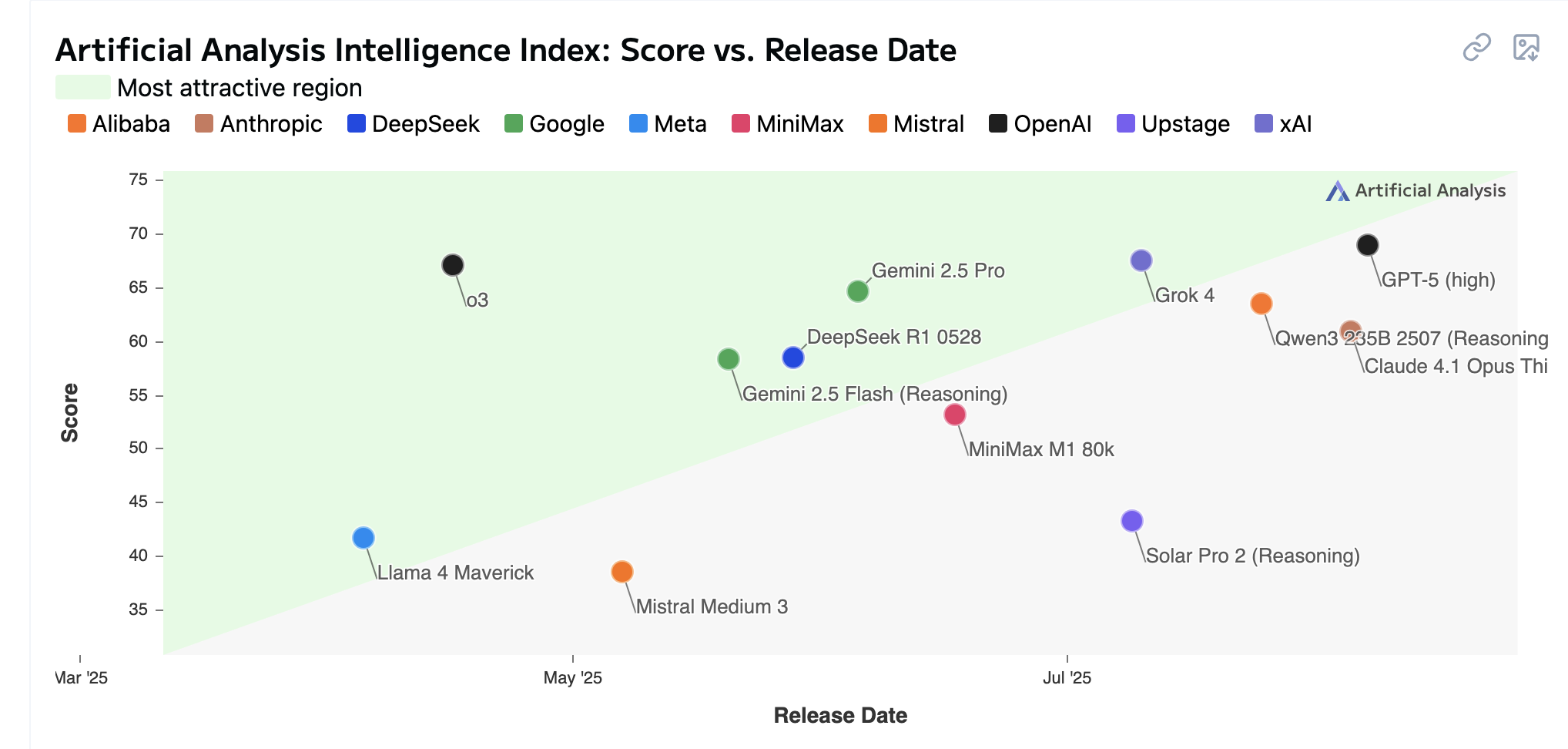

Artificial Analysis Intellligence Index

Artificial Analysis Intelligence Index combine les performances sur sept évaluations : MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2025, et IFBench.

Score vs release date

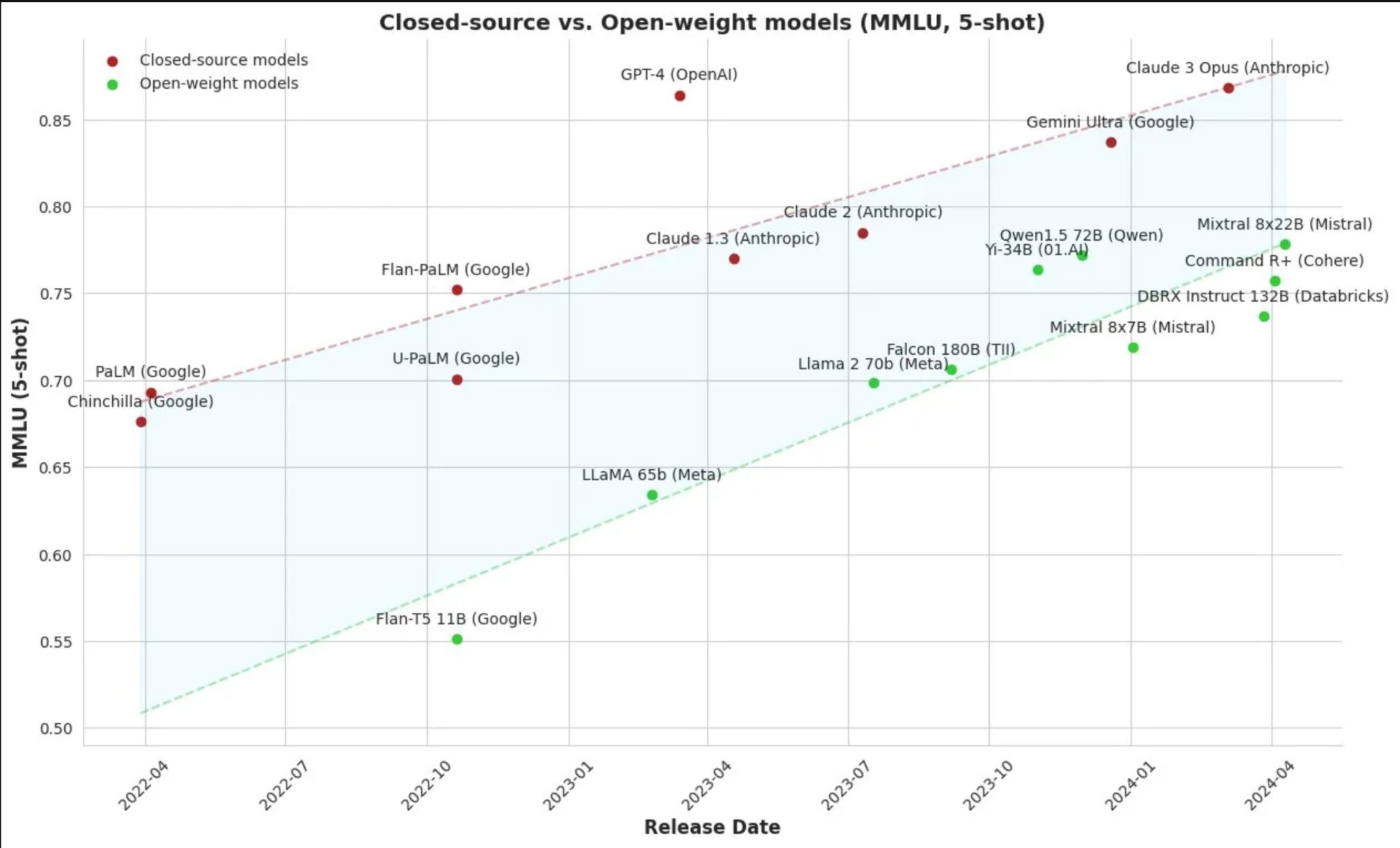

La course: open source vs propriétaires

Les modèles open source rattrapent les modèles closed source

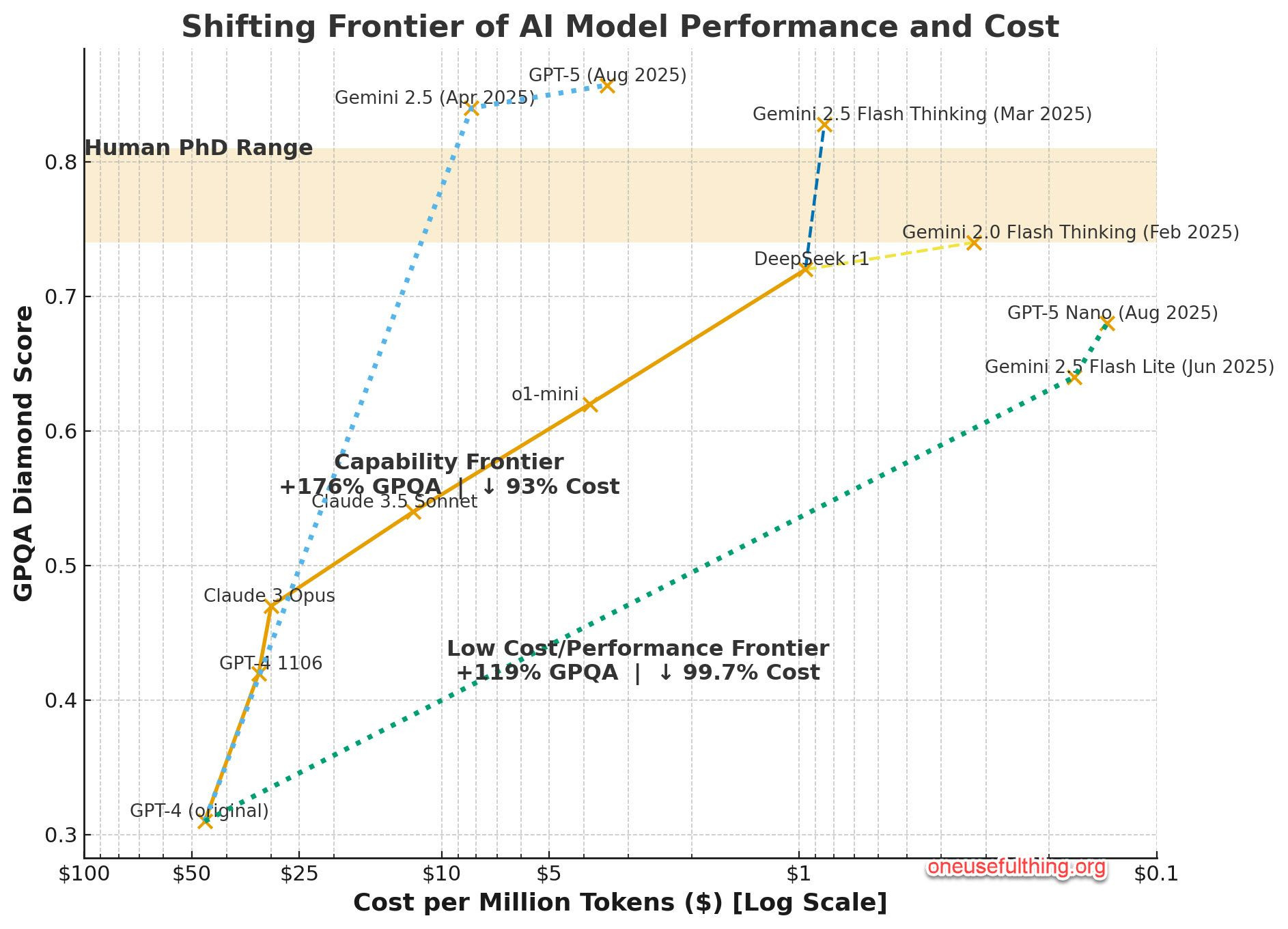

Performance vs Cost - 08/2025

Types de LLMs

- Licences : open source ↔ propriétaires

- Taille & usage :

- Mini-LLMs → Mid-size / spécialisés → Modèles de fondation

- généraux → multi tâches → spécialisés

- Langues : monolingues → multilingues

- Déploiement : local, cloud, embarqués (on-device)

- Entraînement : from scratch, fine-tuné

- Formats : textuels, multimodaux

- Modes d’utilisation : plateforme web ou application, API, intégration locale

Agents

LLMs augmentés

du LLM au LLM agentic : mémoire, outils, planification

Agent mode

les agents: newsletter.maartengrootendorst.com/p/a-visual-guide-to-llm-agents

- mémoire :

- courte : résumé de chaque étape de la conversation dans le prompt

- longue : base de données

- outils: websearch, etc

- Routing: étape du choix de l’outil

- planification : Prompt chaining : décomposition de la requête en plusieurs sous tâches

-

Agent mode: planification + outils + mémoire + … instance serveur

- MCP : standard “universel” de connection. LLM a accès aux sources

- connection à Notion, Excel, Canva

Prompt

- le contexte

- le guider, l’aider à décomposer

-

des exemples si besoin pour ancrer

- démarrer simple, passer progressivement au plus compliqué

Mon temps: écrire des spécifications comme prompts

system prompt vs user prompt

personnalité des modèles: le prompt system

Un prompt système est le fichier de politique et de personnalité de niveau racine que chaque demande d’utilisateur doit respecter. … ‘le manuel non officiel’ des vraies capacités et garde-fous d’un modèle.

focus sur chatGPT

- custom chatGPTs

- websearch

- deep search

- agent mode

sources d’info

- les personnes à suivre: Ethan Mollick, Simon Willinson,

- The Neuron

- evolution génération d’image

- podcast: latent space + a16z

-

Mike Caulfield : do a second pass without putting a thumb on the scale almost always leads to a better result.

- Claude et Excel et ici